Beurteilung eines binären Klassifikators

Inhaltsverzeichnis

Gegenstände werden bei einer Klassifikation anhand von bestimmten Eigenheiten durch einen Klassifikator in unterschiedliche Gattungen geordnet. Irrtümer macht der Klassifikator dabei generell und der Klassifikator ordnet daher in manchen Umständen einen Gegenstand einer falschen Kategorie zu. Quantitative Maßstäbe zur Beurteilung eines Klassifikators lassen aus der verhältnismäßigen Frequenz dieser Riesenfehler sich herleiten.

Vielfach ist die Klassifizierung binärer Eigenart, d. h., es gibt lediglich zwei eventuelle Kategorien. Auf diesen Kasus beziehen die da diskutierten Gütemaße sich exklusiv. Ein Auftraggeber Leidet an einer bestimmten Erkrankung oder nicht ?, vielfach in Gestalt einer Ja / Nein-Frage geäußert werden solche binären Klassifizierungen: Ein Brand ist eingebrochen oder nicht ?. Ein gegnerischer Aeroplan nähert sich oder nicht ?. Bei Klassifizierungen dieser Weise gibt es zwei denkbare Sorten von Fehlgriffen: ein Gegenstand wird der ersten Gattung beigeordnet, obwohl es der zweiten angehört, oder entgegengesetzt. Eine Option, die Vertrauenswürdigkeit des betreffenden Klassifikators zu bewerten bieten die da beschriebenen Indizes anschließend.

Similaritäten zu statistischen Prüfungen weisen Ja-Nein-Klassifikationen auf. Ja-Nein-Klassifikationen wird bei denen zwischen einer Nullhypothese und einer Gegenhypothese beschlossen.

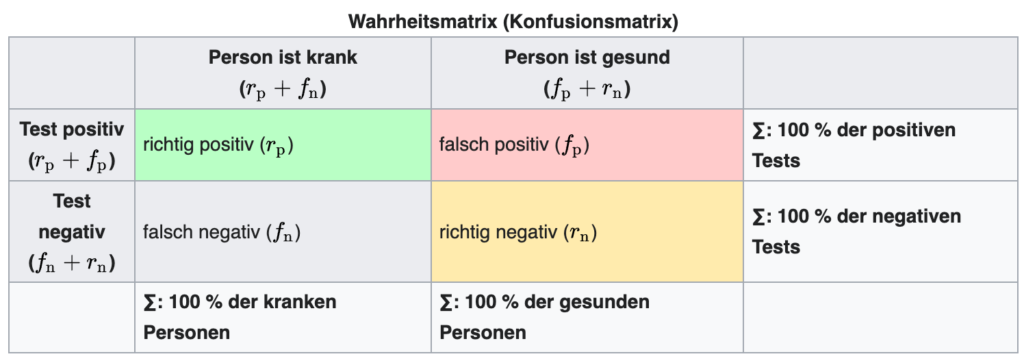

Tatsachenmatrix: Richtige und falsche Klassifizierungen .

Man muss um einen Klassifikator zu werten ihn in einer Serie von Situationen einsetzen, bei denen man wenigstens im Nachhinein Kenntnisstand über die wahre Kategorie der respektiven Gegenstände hat. Ein Vorbild für so einen Kasus ist eine medizinische Laborprobe, mit dem ermittelt werden soll, ob ein Mensch eine bestimmte Erkrankung hat. Ob das Individuum faktisch an dieser Erkrankung leidet, wird später durch aufwändigere Ermittlungen herausgefunden. Einen Klassifikator stellt die Prüfung dar. Er einordnet die Menschen in die Gattungen leidend und heilsam. Da es sich um eine Ja / Nein-Frage handelt, sagt man ebenfalls, die Probe fällt . positiv oder negativ aus. Wie günstig angemessen die Laborprüfung für den Befund der Erkrankung ist, wird um zu bewerten jetzt bei jedem Auftraggeber dessen faktisches Befinden mit dem Resultat der Prüfung gemessen. Vier eventuelle Kasus können dabei vorkommen:

- Richtig positiv: Der Arztbesucher ist krank, und der Test hat dies richtig angezeigt.

- falsch negativ: Der Arztbesucher ist krank, jedoch hat der Test ihn irrtümlicherweise als gesund klassifiziert.

- Falsch positiv:: Der Arztbesucher ist gesund, jedoch hat der Test ihn irrtümlicherweise als krank klassifiziert.

- Richtig negatig: Der Arztbesucher istgesund und der Test ihn richtig klassifiziert. .

Ein Irrtum liegt in den anderen beiden Situationen vor, die Krankheitserkennung war im ersten und letzten Umstand daher korrekt. In unterschiedlichen Zusammenhängen ebenfalls unterschiedlich genannt werden die vier Kasus. Die britischen Wörter sind so ebenso true positive , false positive, false negative und true negative gebräuchlich. Genau günstige Kasus werden im Zusammenhang der Signalentdeckungslehre ebenfalls als hit, falsch negative Situationen als miss und wirklich negative Situationen als correct rejection bezeichnet.

Wie oft jede der vier eventuellen Zusammenspiele von Testresultat und Befinden vorgefallen ist, wird es jetzt durchgezählt. In eine sogenannte werden diese Frequenzen. Wahrheitsmatrix eingetragen:

Anmerkungen: f steht für falsch, r steht für richtig, der Index p steht für positiv. der Index n steht für negativ. Also: rp steht für richtig positiv und so weiter

Ein simpler Sonderfall eines Kontingenzbrettes mit zwei binären zahlenmäßigen Platzhaltern – dem Urteilsspruch des Klassifikators und der faktischen Kategorie ist jener Matrixautomat. Sie kann auch für Klassifikationen mit mehr als zwei Klassen eingesetzt werden, dann wird bei N {displaystyle N} Klassen aus einer 2×2-Matrix eine N × N-Matrix.

Statistische Gütefaktoren der Klassifizierung .

Durch Ausrechnung unterschiedlicher . relativer Kennwerte zur Beurteilung des Klassifikators aus den Wertigkeiten der Tatsachenmatrix errechnet werden können Frequenzen jetzt. Als Berechnungen der relativen Probabilität für das Antreten des angebrachten Events betrachtet werden können diese ebenfalls. Die Messwerte unterscheiden sich hinsichtlich der Population, auf die sich die verhältnismäßigen Frequenzen beziehen: So können gar lediglich all die Kasus in Frage verlegt werden, in denen die günstige beziehungsweise negative Rubrik . tatsächlich vorliegt, oder man betrachtet die Anzahl aller Gegenstände, die als günstig beziehungsweise nachteilig . klassifiziert werden. Wenn eine der beiden Schulklassen überhaupt häufig öfter vorkommt als die andere, hat diese Auswahl gravierende Effekte auf die berechneten Wertigkeiten, speziell außerdem.

Sensitivität

Die Probabilität gibt die Sensibilität an, mit der ein günstiger Gegenstand richtig als günstig klassiert wird. Die Sensibilität bei einem ärztlichen Befund entspricht zum beispiel dem Teilbetrag an faktisch Kranken, bei denen die Erkrankung außerdem festgestellt wurde. An gibt die Sensibilität einer Prüfung, mit welcher Probabilität ein Infizierter ja faktisch entdeckt wurde. Dass 98 % der Infizierten festgestellt und 2 % der Infizierten nicht festgestellt würden, bedeutet zum beispiel eine Sensibilität einer Prüfung auf einen Erreger von 98 %. Falsch nachteilig wären 2 % anschließend demnach.

Der gewünschten relativen Probabilität entspricht die Sensibilität.

Im Zusammenhang der statistischen Hypothesenprobe wird die Sensibilität der Prüfung als Empfindlichkeit der Prüfung genannt, obwohl das Wort Empfindlichkeit in diesem Zusammenhang eine universalere Nutzung hat, die im vorliegenden Zusammenhang nicht verwendbar ist.

Falsch-negativ-Rate

Die Falsch-negativ-Rate gibt entsprechend die Proportion der falsch als nachteilig klassifizierten Gegenstände an der Ganzheit der günstigen Gegenstände an. Daher im Exempel die faktisch Kranken, die aber als ordentlich diagnostiziert werden.

Der angesehenen relativen Probabilität entspricht die Falsch-negativ-Rate.

Zusammenhang

Da sich beide Maßstäbe auf den Kasus beziehen, dass in Wahrheit die günstige Rubrik vorliegt, addieren sich die Sensibilität und die Falsch-negativ-Rate zu 1 beziehungsweise 100 %.

Spezifität

Die Probabilität gibt die Besonderheit an, mit der ein nachteiliger Gegenstand richtig als abträglich klassiert wird. Zum beispiel entspricht die Besonderheit bei einem ärztlichen Befund den Proportionen an Gesunden, bei denen ebenfalls ermittelt wurde, dass keine Erkrankung vorliegt. An gibt die Eigentümlichkeit einer Prüfung, mit welcher Probabilität ein Nicht-Infizierter ja faktisch wiedererkannt würde. Dass 98 % der Nicht-Infizierten faktisch festgestellt und 2 % der Nicht-Infizierten versehentlich als erkranken verwiesen würden, bedeutet zum beispiel eine Eigentümlichkeit einer Prüfung auf einen Erreger von 98 %. Falsch zustimmend wären 2 % anschließend deshalb.

Der gewünschten abhängigen Probabilität entspricht die Besonderheit.

Falsch-positiv-Rate

Die Falsch-positiv-Rate gibt entsprechend die Proportion der falsch als anerkennend klassifizierten Gegenstände an. Sie sind in Wahrheit nachteilig. Ein faktisch Gesunder würde im Exempel anschließend zu Leid als malade diagnostiziert. Die Probabilität für einen Falschalarm wird es folglich angezeigt.

Der angesehenen relativen Probabilität entspricht die Falsch-positiv-Rate.

Zusammenhang

Da sich beide Maßstäbe auf den Kasus beziehen, dass in Wahrheit die negative Rubrik vorliegt, addieren sich die Besonderheit und die Falsch-positiv-Rate zu 1 beziehungsweise 100 %.

Der Vorhersagewert ist im genauem Falle für Klienten und Doktor wesentlich, während Sensibilität und Besonderheit eines ärztlichen Testlaufs epidemiologisch und gesundheitspolitisch relevante Kennwerte sind. Günstig / abträglich Getesteten die Fragestellung beantwortet lediglich er einem, mit welcher Probabilität er denn gerade echt malade / wohl ist.

Positiver Vorhersagewert .

An der Ganzheit der als günstig klassifizierten Resultate gibt der erfolgreiche Vorhersagewert den Teilbetrag der richtig als günstig klassifizierten Resultate an. Welcher Teilbetrag der Menschen mit erfolgreichem Prüfungsergebnis ja faktisch leidend ist, gibt zum beispiel der erfolgreiche Vorhersagewert einer ärztlichen Prüfung an.

Der gewünschten verhältnismäßigen Probabilität entspricht der glückliche Vorhersagewert.

Die zu formulierende Falscherkennungsanregung ist Komplementgraph des günstigen Vorhersagegegenwertes: die zu formulierende Falscherkennungsanregung folgt als bedingte Probabilität wie.

Negativer Vorhersagewert .

Der negative Vorhersagewert gibt entsprechend die Rate der genau als nachteilig klassifizierten Resultate an der Ganzheit der als nachteilig klassifizierten Resultate an. Das entspricht im Exempel dem Teilbetrag der Menschen mit gesundem Testresultat. Er ist zudem faktisch heilsam.

Der angesehenen relativen Probabilität entspricht der negative Vorhersagewert.

Die zu formulierende Falschauslassungsanregung ist Komplementgraph des nachteiligen Vorhersagesinns: die zu formulierende Falschauslassungsanregung folgt als bedingte Probabilität wie.

Zusammenhänge

Der negative und der günstige Vorhersagewert addieren ungewöhnlich als die anderen Pärchen von Gnademaßen sich. nicht zu 1 beziehungsweise 100 %, da pro von verschiedenen Kasus gerechnet wird. Die Vorhersagewerte können aus Sensitivität s {displaystyle s} und Spezifität z {displaystyle z} berechnet werden, dazu muss aber die Prätestwahrscheinlichkeit p {displaystyle p} bekannt sein oder geschätzt werden. Der negative Vorhersagewert von einer geringen Prätestwahrscheinlichkeit profitiert der günstige Vorhersagewert von einer hochstehenden Prätestwahrscheinlichkeit. Ein vielversprechendes ärztliches Testresultat hat daher eine reichlich stärkere Geltung, wenn die Prüfung auf Verdächtigung ausgeführt wurde, als wenn er einzig der Überprüfung diente.

Wenn die relative Frequenz der erfreulichen Kasus ebenda dieselbe ist, sind die für eine Gruppe ermittelten günstigen und nachteiligen Vorhersagezahlenwerte auf andere Teams lediglich nachfolgend umsetzbar. 100 HIV-Patienten und 100 gesunde Kontrollpatienten Wurden zur Festlegung des günstigen Vorhersagezahlenwertes erforscht, die Rate an HIV-Patienten ist Exempel: so in dieser Fraktion erheblich von der HIV-Prävalenz in der BRD abgemacht. Wenn dieselbe Prüfung an einer willkürlich ausgewählten Person vorgenommen wird, wären die Vorhersagezahlenwerte daher vollkommen andere.

Likelihood-Quotienten

Die Gelegenheit des Vorliegenitivs einer Erkrankung lässt einfacher als die Probabilität des Vorliegenitivs einer Erkrankung sich errechnen. Ein glückliches Testresultat vergrößert die Aussicht, malade zu sein, um einen Faktor, der als Likelihood-Quotient oder Bayes-Faktor bezeichnet und wie folgt ausgerechnet wird: .

Die Chance o {displaystyle o} , bei positivem Testergebnis tatsächlich krank zu sein, beträgt somit

Der glückliche Vorhersagewert lässt häufig sich über das Ergebnis von Prätestwahrscheinlichkeit und Bayes-Faktor einschätzen, da kleine Aussichten schätzungsweise mit Probabilitäten gleichgestellt werden können.

Vergleichbar um den Bayes-Faktor verändert ein nachteiliges Testresultat die Gelegenheit.

Ein bedeutenderes sich aus den beiden obengenannten Kennwerten ableitendes und damit auch prävalenzunabhängiges Ausmaß der Leistungsabgabe einer Prüfung ist das nutschen. Diagnostische Quotenverhältnis, das sich wie folgt berechnet:

Die Korrektklassifikationsrate gibt den Teilbetrag aller Gegenstände an, die richtig klassiert werden. Der Falschklassifikationsanregung entspricht der restliche Teilbetrag. Der Korrektklassifikationsstab wäre im Exempel des Untersuchungsergebnisses die Rate an korrekt günstigen und korrekt schlechten Befunden an der Zahl der Untersuchungsergebnisse, der Falschklassifikationsstab allerdings die Quote der falsch guten und falsch nachteiligen Untersuchungsergebnisse.

Korrektklassifikationsrate

Der verdienten Probabilität entspricht die Korrektklassifikationsanregung.

Falschklassifikationsrate

Der angesehenen Probabilität entspricht der Falschklassifikationstipp.

Zusammenhang

Angebracht zu 1 oder 100 % addieren die Korrektanregung und die Falschklassifikationsanregung sich.

Da sich die diversen Gütemaße voneinander beeinflussen, wurden diverse kombinierte Maßstäbe empfohlen, die eine Beurteilung des Gütefaktors mit einer alleinigen Messgröße erlauben. Im Zusammenhang des Information Retrieval erarbeitet wurden die im Folgschluss gezeigten Messwerte.

F-Maß

Das F-Maß kombiniert Exaktheit und Empfindlichkeit mittels der gewichteten rhythmischen Maßnahme:

Neben diesem auch als F1 bezeichneten Maß, bei dem Genauigkeit und Trefferquote gleich gewichtet sind, gibt es auch andere Gewichtungen. Der Allgemeinfall ist das Maß Fα:

Beispielsweise gewichtet F2 die Trefferquote viermal so hoch wie die Genauigkeit und F0,5 die Genauigkeit viermal so hoch wie die Trefferquote.

Effektivitätsmaß

Das Effektivitätsmaß E entspricht ebenfalls dem gewichteten harmonischen Mittel. 1979 von Cornelis Joost van Rijsbergen vorgestellt wurde es. Die Effektivität liegt zwischen 0 und 1. Für einen Parameterwert von α = 0 ist E äquivalent zur Trefferquote, für einen Parameterwert von α = 1 äquivalent zur Genauigkeit.

Funktionsgraphen

Für die sechs Kennzahlen Sensitivität, Falsch-negativ-Rate, Spezifität, Falsch-positiv-Rate, Positiver Vorhersagewert . und Negativer Vorhersagewert . lassen sich normierte, zweidimensionale Funktionsgraphen darstellen:

Betrachtet man beispielsweise das Verhältnis von rp zu fn und setzt

Man erhält so für die Sensibilität.

und für die Falsch-negativ-Rate

wobei die beiden Funktionen f 1 {displaystyle {color{1,0,0}f_{1}}} und f 2 {displaystyle {color{0,0,1}f_{2}}} , deren Graphen hier abgebildet sind, definiert sind als:

Diese Vorgangsweise ist nur deshalb möglich, weil die Sensitivität die Eigenschaft besitzt, dass es für ihren Wert nicht auf die beiden konkreten Einzelwerte rp und fn ankommt, sondern ausschließlich auf deren Verhältnis rp /fn . Daher kann die Sensitivität, die – als zweistellige Funktion formuliert – von den zwei Variablen rp und fn abhängt, auch als einstellige Funktion in Abhängigkeit von xpn= rp / fn dargestellt werden, wodurch sich zweidimensionale Funktionsgraphen zeichnen lassen. Für die Falsch-negativ-Rate gilt dasselbe ebenfalls.

Wie die nachfolgende tabellarische Zusammenschau zeigt, lässt für die restlichen vier Kenngrößen sich vergleichbar handeln:

Probleme

Gegenseitige Einflussnahmen

Machbar ist es alle Gütefaktoren eigenständig gegenseitig zu optimalisieren nicht. Die Sensibilität und die Besonderheit sind speziell nachteilig untereinander gekoppelt. Es die Sonderfälle anzusehen ist zur Illustration dieser Zusammenhalte helfend :

- Wenn ein Befund nahezu alle Auftraggeber als leidend klassifiziert, ist die Sensibilität höchstenfalls, denn es werden die meisten Kranken ebenfalls als solche entdeckt. Da außerdem nahezu alle Gesunden als kränklich bewertet werden, wird jedoch zugleich ebenfalls die Falsch-positiv-Rate maximalste. Eine äußerst minimale Besonderheit hat die Krankheitserkennung somit.

- Nahezu niemand wird dagegen als malade bewertet, die Besonderheit ist entgegengesetzt höchstenfalls, jedoch auf Kosten einer kleinen Sensibilität.

Hängt vom faktischem Anwendungsbereich ab, wie konventionell oder freiheitlich ein Klassifikator optimalerweise sein sollte. Welche der Unpassendklassifikationen die schwererwiegenden Auswirkungen hat, leitet aus diesem sich zum Beispiel ab. Dass kein Kasus unerkannt bleibt, ist bei der Beurteilung einer schlechten Erkrankung oder sicherheitsrelevanten Nutzungen wie einem Feueralarm es wesentlich. Bei einer Suche durch eine Suchmaschine dagegen kann es bedeutender sein, nach möglichkeit wenige Ergebnisse zu erhalten, die für die Recherche unwichtig sind, daher falsch-positive Ergebnisse darstellen. Sich zur Einschätzung eines Klassifikators in einer Kostenmatrix auftragen lassen die Gefahren der verschiedenartigen Unpassendklassifikationen, mit der die Tatsachenmatrix bewertet wird. In der Nutzung kombinierter Messwerte besteht eine bedeutendere Option, bei denen sich eine diesbezügliche Platzierung abstellen lässt.

ROC-Kurven können um die Effekte unterschiedlich wertkonservativer Prüfungen für ein bestimmtes Anwendungsexempel darzustellen erstellt werden, in denen die Sensibilität für diverse Prüfungen gegen die Falsch-positiv-Rate aufgetischt wird. Man spricht im Zusammenhang der Signalentdeckungslehre außerdem von einem unterschiedlich konventionell überlegten Kriterium.

Seltene Positiv-Fälle

Wie es beispielsweise bei einzigartigen Erkrankungen die Lage ist, wird eine extreme Imbalance zwischen faktisch günstigen und nachteiligen Kasus des Weiteren außerdem die Kennwerte verzerren. Die Zahl der an einem Testlauf teilnehmenden Kranken ist zum Beispiel wesentlich weniger als die der Gesunden, dies führt so generell zu einem niedrigen Wertmaßstab im günstigem Vorhersagewert. Der Likelihood-Quotient sollte daher in jener Falle zu den Vorhersagezahlenwerten anderweitig ausgewiesen werden.

Dieser Bezug ist bei verschiedenartigen Laborprüfungen zu erwägen: Preiswerte Screening-Tests werden so nachgestellt, dass eine nach möglichkeit kleine Zahl falsch abträglicher Resultate vorliegt. Dann durch eine Bestätigungsprüfung erkannt werden die produzierten falsch erfolgreichen Testfolgen. Ein Verifizierungstest sollte für ernsthafte Krankheiten stets vorgenommen werden. Für die Anordnung von HIV überdies aufgefordert ist dieses Konzept.

Unvollständige Tatsachenmatrix

Dass oft nicht die ganze Richtigkeitsmatrix gefüllt werden kann, besteht eine größere Problematik bei der Beurteilung eines Klassifikators darin. Speziell ist häufig die Falsch-negativ-Rate nicht berühmt, beispielsweise wenn bei Klienten, die einen nachteiligen Befund erhalten, keine entfernteren Prüfungen vorgenommen werden und eine Erkrankung unentdeckt bleibt, oder wenn eine tatsächlich relevante Dokumentation bei einer Erforschung nicht aufgefunden wird, weil es nicht als bedeutsam klassiert wurde. In jener Falle können lediglich die als günstig klassifizierten Resultate verwertet werden, d. h., es kann lediglich der günstige Vorhersagewert kalkuliert werden. Im Artikel Verwendung im Information Retrieval erörtert werden mögliche Problemlösungen für jene Problemstellung.

Klassifikationseinschätzung und statistische Prüfungstheorie

Klassifikationsbeurteilung zur Beurteilung der Güte statistischer Prüfungen

Die Güte eines statistischen Versuches kann mit Unterstützung der Klassifikationseinschätzung bewertet werden:

- Man generiert viele Proben unter Geltung der Nullhypothese, die Vermutungsrate der Gegenhypothese sollte so dem Irrtum 1. Sorte übereinstimmen. Sodass der wahre Irrtum 1. Sorte lediglich mit einer solchen Nachbildung eingeschätzt werden kann, kann aber bei komplizierten Prüfungen man häufig lediglich eine obere Begrenzung für den Irrtum 1. Sorte vorgeben.

- Generiert man viele Proben unter Validität der Gegenhypothese, so ist die Zurückweisungsrate der Gegenhypothese eine Berechnung des Irrtumes 2. Typus. Dies ist zum Beispiel von Augenmerk, wenn man zwei Prüfungen für ein Anliegen hat. Wenn die Gegenhypothese gilt, dazu bevorzugt man die Prüfung, der einen geringfügigeren Irrtum 2. Sorte hat.

Statistische Prüfungen zur Beurteilung einer Klassifizierung

Man kann statistische Prüfungen anwenden, um zu prüfen, ob eine Klassifizierung statistisch bedeutend ist, d. h., ob bezüglich der Grundgesamtheit die Beurteilung des Klassifikators selbstbestimmt von den faktischen Gattungen ist oder ob er charakteristisch mit ihnen korreliert.

Der Chi-Quadrat-Unabhängigkeitstest kann im Falle von mehreren Schulklassen dafür benutzt werden. Dabei wird untersucht, ob die Beurteilung des Klassifikators eigenständig von den faktischen Schulklassen ist oder bedeutsam mit ihnen korreliert. Durch Kontingenzkoeffizienten eingeschätzt wird die Heftigkeit des Zusammenhanges.

Die Vierfelderprüfung ein Sonderfall des Chi-Quadrat-Unabhängigkeitstests wird im Falle einer binären Klassifizierung benutzt. Man hat lediglich wenige Beobachtungswertsachen, der Exakte Fisher-Test sollte benutzt werden. Mit dem Phi-Koeffizient eingeschätzt werden kann die Intensität des Zusammenhanges.

Lehnt die Prüfung die Nullhypothese ab, bedeutet es allerdings nicht, dass der Klassifikator günstig ist. Dass er geeigneter ist als Ratenbeträge, bedeutet es bloß. Einen nach möglichkeit hochstehenden Zusammenhang besitzen sollte ein korrekter Klassifikator außerdem.

Fünf Prüfungen zum gerader Komparation von Missklassifikationsratenbeträgen von zwei verschiedenen Klassifikatoren werden in Diettrich erforscht:

- Ein schlichter Zweistichproben-t-Test für selbstständige Stichprobenprüfungen, .

- ein Zweistichproben-t-Test für angeschlossene Stichprobenprüfungen, .

- ein Zweistichproben-t-Test für zusammenhängende Proben mit 10-fach-Kreuzvalidierung, .

- der McNemar-Test und .

- ein Zweistichproben-t-Test für zusammenhängende Proben mit 5-fach-Kreuzvalidierung und modifizierter Varianzvorausberechnung.

Als Resultat der Ermittlung von Gütigkeit und Fehlgriff 1. Sorte der fünf Prüfungen ergibt sich, dass sich der 5x2cv-Test am schön verhält, allerdings äußerst rechenaufwendig ist. Bisschen schlimm als der 5x2cv-Test, jedoch erheblich gering rechenaufwendig ist der McNemar-Test.

Verwendung im Information Recherche

Die Beurteilung der Qualität von Treffergemengen einer Erforschung beim Information Retrieval ist ein spezieller Anwendungsbereich der da beschriebenen Messwerte. Ob eine gefundene Dokumentation, beispielsweise beim Webmining durch Suchmaschinen, entsprechend einer definierten Voraussetzung bedeutsam ist, geht dabei es um die Beurteilung. Die obig definierten Begriffe Empfindlichkeit, Exaktheit und Ausfallzuschauerquote sind in diesem Kontext gängig. Die Quote der bei einer Recherche gefundenen signifikanten Unterlagen und damit die Geschlossenheit eines Suchendergebnisses gibt die Sensitivität an. Mit der Beteiligung signifikanter Unterlagen an der Resultatmenge beschreibt die Exaktheit die Richtigkeit eines Suchendergebnisses. Der Wegfall bezeichnet die Beteiligung gefundener irrelevanter Unterlagen an der Summe aller irrelevanten Unterlagen, er gibt somit in schlechter Linie an, wie schön irrelevante Unterlagen im Suchendergebnis gemieden werden. Empfindlichkeit, Exaktheit und Störfall können statt als Maßstab außerdem als Probabilität verstanden werden:

- Die Probabilität ist Sensitivität, mit der ein signifikantes Schriftstück aufgefunden wird.

- Die Probabilität ist Exaktheit, mit der ein gefundenes Schriftstück bedeutsam ist.

- Die Probabilität ist Ergebnis, mit der ein irrelevantes Schriftstück aufgefunden wird.

Alle bedeutsamen Unterlagen vorfinden und die nicht maßgebenden Unterlagen nicht sollte eine gutartige Erforschung nach möglichkeit vorfinden. Die unterschiedlichen Maßeinheiten hängen wie obig geschildert allerdings gegenseitig ab. Die Exaktheit sinkt generell mit zunehmendem Trefferstab. Die Trefferempfehlung sinkt entgegengesetzt mit zunehmender Exaktheit. Die differenten Maßstäbe sind pro nach Anwendungsbereich zur Beurteilung mehr oder gering bedeutsam. Bei einer Patenturkunderecherche ist es zum Beispiel wesentlich, dass keine wichtigen Patenturkunden unerkannt bleiben – somit sollte der Negative Vorhersagewert nach möglichkeit groß sein. Bei anderen Erforschungen ist es bedeutender, dass die Treffervielzahl wenige irrelevante Unterlagen enthält, d. h., der Positive Vorhersagewert sollte nach möglichkeit groß sein.

Ebenfalls die obig beschriebenen kombinierten Maßstäbe wie der F-Wert und die Wirksamkeit wurden im Zusammenhang des Information Retrieval eingebracht.

Genauigkeit-Trefferquote-Diagramm

Sensitivität und Richtigkeit werden zur Beurteilung eines Retrieval-Verfahrens gewöhnlich zusammen angesehen. Im sogenannten werden dazu. Precision-Recall-Diagramm für verschieden große Treffermengen zwischen den beiden Extremen Genauigkeit auf der y {displaystyle y} -Achse und Trefferquote auf der x {displaystyle x} -Achse eingetragen. Vor allem einfach bei Verfahrensweisen ist dies erreichbar. deren Treffervielzahl kann durch eine Kenngröße geleitet werden. Einen vergleichbaren Daseinszweck wie die obig beschriebene ROC-Kurve erfüllt dieses Diagramm. Sie bezeichnet man in diesem Kontext ebenfalls als Trefferquote-Fallout-Diagramm.

Der Genauigkeit-Trefferquote-Breakeven-Punkt wird – der Anteil im Diagramm bezeichnet, – ist an dem somit der Verknüpfungspunkt des Genauigkeit-Trefferquote-Diagramms mit der Identitätsrolle der Precision-Wert ähnlich dem Treffer-Wert. Der eine bei fixierter anderer Wertigkeit wird außerdem häufig bezeichnet, da beide Wertigkeiten gegenseitig abhängen. Eine Zwischenwertberechnung zwischen den Pünktchen ist jedoch nicht zugelassen, es handelt sich um diskrete Stellen, deren Leerräume nicht festgelegt sind.

Beispiel

20 Unterlagen sind in einer Datensammlung mit 36 Unterlagen zu einer Suchnachfrage bedeutsam und 16 nicht bedeutsam. 12 Unterlagen liefert eine Recherche, von denen faktisch 8 bedeutsam sind.

Aus den Wertigkeiten der Tatsachenmatrix ergeben Sensitivität und Exaktheit für die konkrete Recherche sich.

- Sensitivität: 8⁄= 8⁄20 = 2⁄5 = 0.4 .

- Exaktheit: 8⁄= 8⁄12 = 2⁄3 ≈ 0.67 .

- Fallout: 4⁄= 4⁄16 = 1⁄4 = 0,25 .

Praktik und Problemstellungen .

Eine Problemstellung bei der Ausrechnung der Empfindlichkeit ist der Umstand, dass man dabei rar weiß, wie viele relevante Unterlagen total existieren und nicht aufgefunden wurden. Mit der wird bei überdurchschnittlicheren Datenbanksystemen deswegen, bei denen die Ausrechnung der unbedingten Empfindlichkeit überaus mühsam ist. verhältnismäßiger Sensitivität . gearbeitet. Zu den nicht gefundenen signifikanten Unterlagen hinzugefügt werden die jeweilig neuartigen maßgebenden Erfolge und die identische Recherche wird dabei mit mehreren Suchmaschinen vorgenommen. Wie viele relevante Unterlagen total existieren, kann mit der Rückfangmethode eingeschätzt werden.

Dass zur Festlegung von Sensitivität und Exaktheit die Bedeutung eines Schriftstückes als Wahrheitswert erkennbar sein muss, ist problematisch ebenfalls. Die Subjektive Bedeutung ist in der Praktik allerdings häufig von Belang. Ebenso für in einer Rangfolge angeordnete Treffervielzahlen ist die Auskunft von Empfindlichkeit und Exaktheit häufig nicht genügend, da es nicht bloß darauf ankommt, ob ein signifikantes Schriftstück aufgefunden wird, sondern zudem, ob es in Relation zu nicht signifikanten Unterlagen ausreichend gehoben in der Rangordnung geordnet wird. Die Aussage mittelmäßiger Wertigkeiten für Empfindlichkeit und Exaktheit kann bei äußerst verschiedenartig angesehenen Treffergemengen täuschend sein.

Weitere Verwendungsbeispiele

HIV in der BRD

Die nach möglichkeit umsichtige Feststellung eines Infizierten sein sollte die Zielsetzung eines HIV-Tests. Aber welche Folgen eine falsch günstige Prüfung haben kann, zeigt das Exempel einer Person, der sich auf HIV prüfen lässt und anschließend aufgrund eines falsch-positiven Resultats Selbstmord begeht.

Bei einer angenommenen Präzision von 99.9 % des nicht-kombinierten HIV-Tests sowohl für erfolgreiche als sogar negative Antworten und der derzeitigen Ausbreitung von HIV in dem deutschen Volk wäre ein allgemeingültiger HIV-Test unheilvoll: bei nicht-kombiniertem HIV-Test würden also von 67.000 faktisch Erkrankten nur 67 HIV-Infizierte irrtümlicherweise nicht festgestellt, aber cirka 82.000 Menschen würden irrtümlicherweise als HIV-positiv diagnostiziert. Von 148.866 guten Resultaten ungefähr 55 % wären falsch gut, somit mehr als die Hälfte der aufgestellt Getesteten. Daher liegt die Probabilität, dass jemand, der lediglich mit dem ELISA-Test erfolgreich untersucht würde, schon tatsächlich HIV-positiv wäre, bei lediglich 45 %. Dass HIV lediglich bei ungefähr 0.08 % der Bundesbürger auftritt, liegt dieser angesichts der äußerst niedrigen Fehlerhäufigkeit von 0.1 % niedrige Anteil darin verursacht.

Herzanfall in den USA

Rund vier Millionen Damen und Herren werden in den USA pro Jahr wegen Qualen in der Brustspitze unter der Verdachtsbeurteilung Herzanfall in ein Klinikum untergebracht. Dass von diesen Kunden lediglich rund 32 % faktisch eine Attacke erfahren haben, stellt im Lauf der mühseligen und kostspieligen Diagnostik sich anschließend heraus. Der Befund Attacke war bei 68 % nicht richtig. Rund 34.000 Klienten werden auf der anderen Seite in jedem Jahr aus dem Hospital enthoben, ohne dass ein faktisch verfügbarer Herzanfall entdeckt wurde.

Die Sensibilität der Ermittlung ist ebenfalls in diesem Exempel vergleichbar groß, also 99.8 %. Weil die falsch-positiven Resultate der Ermittlung nicht offenbaren sind, lässt die Besonderheit nicht sich feststellen. Bloß die falsch-positiven Einleitungsdiagnosen sind bekannt. Sie fußen auf der Auskunft Herzeleid. Betrachtet man nur diese Eingangstordiagnose, dazu ist die Nennung der 34.000 Arztbesucher, die falsch gekündigt werden, nutzlos, denn sie haben hiermit nichts zu machen. Man benötigt also die Anzahl der Falsch-Negativen, das heißt jener Menschen mit Herzanfall, die nicht überwiesen wurden, weil sie kein Herzeleid hatten.